更新时间:2025-03-04 gmt 08:00

推理部署使用场景-九游平台

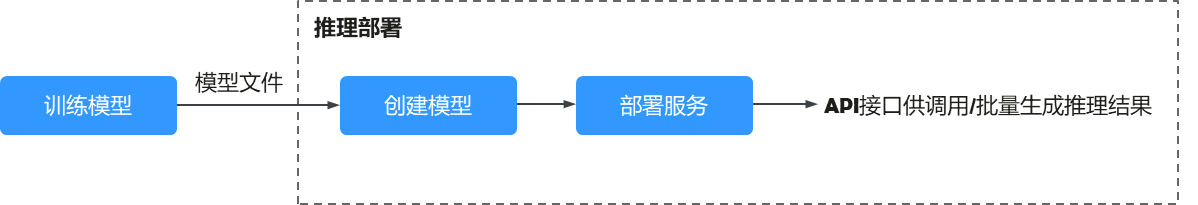

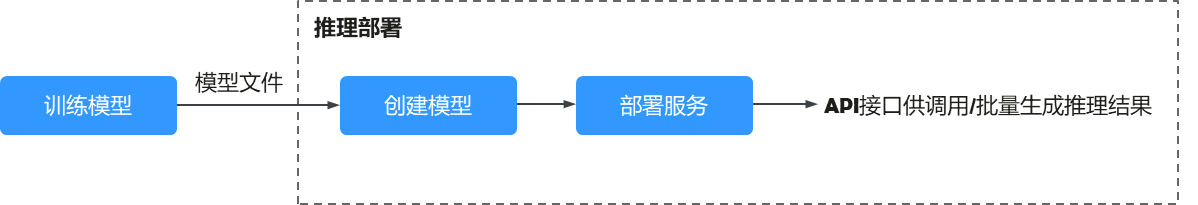

ai模型开发完成后,在modelarts服务中可以将ai模型创建为模型,将模型快速部署为推理服务,您可以通过调用api的方式把ai推理能力集成到自己的it平台,或者批量生成推理结果。

图1 推理简介

- 准备推理资源:根据实际情况选择部署服务所需要的资源类型。modelarts为您提供公共资源池和专属资源池。如果使用专属计算资源,您需要先购买并创建专属资源池,详情请参见创建专属资源池。

- 训练模型:可以在modelarts服务中进行,也可以在您的本地开发环境进行,本地开发的模型需要上传到华为云obs服务。

- 创建模型:把模型文件和推理文件导入到modelarts的模型仓库中,进行版本化管理,并构建为可运行的模型。

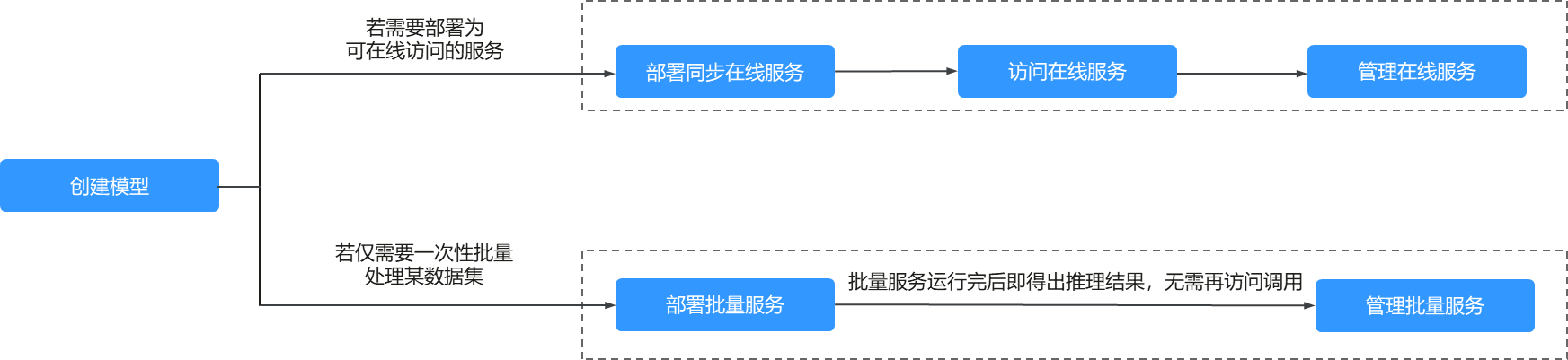

- 部署服务:模型构建完成后,根据您的业务场景,选择将模型部署成对应的服务类型。

- 将模型部署为实时推理作业

将模型部署为一个web service,并且提供在线的测试ui与监控功能,部署成功的在线服务,将为用户提供一个可调用的api。

- 将模型部署为批量推理服务

批量服务可对批量数据进行推理,完成数据处理后自动停止。

图2 不同类型的推理作业使用场景

- 将模型部署为实时推理作业

相关文档

意见反馈

文档内容是否对您有帮助?

提交成功!非常感谢您的反馈,我们会继续努力做到更好!

您可在查看反馈及问题处理状态。

系统繁忙,请稍后重试

如您有其它疑问,您也可以通过华为云社区问答频道来与我们联系探讨