modelarts standard使用流程-九游平台

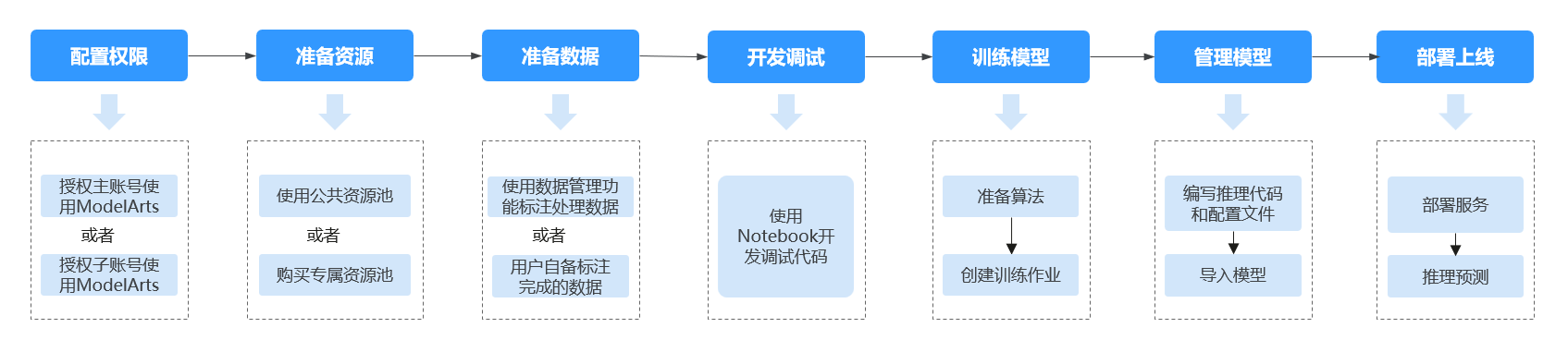

本章节旨在帮助您了解modelarts standard的基本使用方法,帮助您快速上手modelarts服务。

面向熟悉代码编写和调测,熟悉常见ai引擎的开发者,modelarts不仅提供了在线代码开发环境,还提供了从数据准备、模型训练、模型管理到模型部署上线的端到端开发流程(即ai全流程开发)。

本文档介绍了如何在modelarts管理控制台完成ai开发,如果您习惯使用api或者sdk进行开发,建议查看《modelarts sdk参考》和《modelarts api参考》获取帮助。

使用ai全流程开发的端到端示例,请参见 《快速入门》 和《最佳实践》。

standard使用场景介绍

- standard的自动学习可以帮助用户零代码构建ai模型。自动学习功能根据标注数据自动设计模型、自动调参、自动训练、自动压缩和部署模型。开发者无需专业的开发基础和编码能力,只需上传数据,通过自动学习界面引导和简单操作即可完成模型训练和部署。具体请参见自动学习简介。

- standard的workflow是一套低代码的ai开发流水线工具,覆盖数据标注、数据处理、模型开发、训练、模型评估、部署上线等步骤,提供可视化的工作流运行方式。具体请参见什么是workflow。

- standard的开发环境notebook提供了云上jupyterlab环境和本地ide插件,方便用户编写训练推理代码,并使用云上资源进行代码调试。具体请参见notebook使用场景。

- standard的模型训练功能提供了界面化的训练调试环境和生产环境,用户可以使用自己的数据和算法,利用standard提供的计算资源开展模型训练。具体请参见使用modelarts standard训练模型。

- standard的推理部署功能提供了界面化的推理部署生产环境,ai模型开发完成后,在standard中可以纳管ai模型并快速部署为推理服务,您可以进行在线推理预测,也可以通过调用api把ai推理能力集成到自己的it平台。具体请参见推理部署使用场景。

standard使用流程说明

modelarts standard平台提供了从数据准备到模型部署的ai全流程开发,兼容开发者的使用习惯,支持多种引擎和用户场景,使用自由度较高。针对ai开发的每个环节,standard功能使用相对自由,您可以根据实际需要选择其中的环节。下文介绍使用modelarts平台,从准备数据到完成模型开发上线的全流程。

|

流程 |

子任务 |

说明 |

详细指导 |

|---|---|---|---|

|

配置权限 |

配置modelarts委托授权 |

modelarts功能使用还依赖与其他云服务的交互,需要先配置委托授权,允许modelarts访问相关依赖服务。 |

|

|

创建obs桶(可选) |

创建obs桶用于modelarts存储数据 |

由于modelarts本身没有数据存储的功能,使用modelarts standard进行ai开发过程中的输入数据、输出数据、中间缓存数据都可以在obs桶中进行存储、读取。因此,建议您在使用modelarts之前先创建一个obs桶。 创建obs桶可以提前完成,也可以在后续使用到时再创建。 |

|

|

准备资源(可选) |

创建standard专属资源池 |

modelarts standard支持公共资源池和专属资源池。 公共资源池:方便快捷,无需创建,创建训练推理任务时直接选择即可。此时,忽略此步骤。 专属资源池:用户独占资源,需要先购买创建。如果使用专属资源池,需要完成此步骤。 |

|

|

准备数据(可选) |

创建数据集 |

modelarts standard提供了数据管理功能,用户可以在modelarts standard中创建数据集,用于管理、预处理、标注数据。 如果用户已经准备了可用于训练的数据,直接上传到obs即可,无需使用数据管理功能。 |

|

|

开发调试 |

创建notebook |

创建一个notebook作为开发环境,用于调试训练和推理代码。 建议先在开发环境中调试完成训练代码后再创建生产训练作业。 |

|

|

训练模型 |

准备算法 |

创建训练作业前需要先准备算法,可以订阅ai gallery中的算法,也可以使用用户自己的算法。 |

|

|

创建训练作业 |

创建一个训练作业,选择可用的数据集版本,并使用前面编写完成的训练脚本。训练完成后,将生成模型并存储至obs中。 |

||

|

管理模型 |

编写推理代码和配置文件 |

针对您生成的模型,建议您按照modelarts提供的模型包规范,编写推理代码和配置文件,并将推理代码和配置文件存储至训练输出位置。 |

|

|

创建模型 |

将训练完成的模型导入至modelarts创建为模型,方便将模型部署上线。 |

||

|

部署模型 |

部署服务 |

modelarts支持将模型部署为在线服务、批量服务和边缘服务。 |

|

|

访问服务 |

服务部署完成后,针对在线服务和边缘服务,您可以访问并使用服务,针对批量服务,您可以查看其预测结果。 |

相关文档

意见反馈

文档内容是否对您有帮助?

如您有其它疑问,您也可以通过华为云社区问答频道来与我们联系探讨