在notebook中通过dockerfile从0制作自定义镜像用于推理-九游平台

场景说明

针对modelarts目前不支持的ai引擎,您可以通过自定义镜像的方式将编写的模型导入modelarts,创建为模型。

本文详细介绍如何在modelarts的开发环境notebook中使用基础镜像构建一个新的推理镜像,并完成模型的创建,部署为在线服务。本案例仅适用于华为云北京四和上海一站点。

操作流程如下:

- step1 在notebook中构建一个新镜像:在modelarts的开发环境notebook中制作自定义镜像,镜像规范可参考创建模型的自定义镜像规范。

- step2 构建成功的镜像注册到镜像管理模块:将构建成功的自定义镜像注册到modelarts的镜像管理模块中,方便下一步调试。

- step3 在notebook中变更镜像并调试:在notebook中调试镜像。

- step4 使用调试成功的镜像用于推理部署:将调试完成的镜像导入modelarts的模型管理中,并部署上线。

step1 在notebook中构建一个新镜像

本章节以modelarts提供的基础镜像tensorflow为例介绍如何在modelarts的notebook中构建一个新镜像并用于模型部署。

- 登录modelarts控制台,在左侧导航栏中选择“全局配置”,检查是否配置了访问授权。如果未配置,请先配置访问授权。参考使用委托授权完成操作。

- 登录modelarts控制台,在左侧导航栏中选择“开发环境 > notebook”,进入“notebook”管理页面。

- 单击右上角“创建”,进入“创建notebook”页面,请参见如下说明填写参数。

- 填写notebook基本信息,包含名称、描述、是否自动停止。

- 填写notebook详细参数,如选择镜像、资源规格等。

- “镜像”:选择公共镜像下任意一个支持cpu类型的镜像,例如:tensorflow2.1-cuda10.1-cudnn7-ubuntu18.04

- “资源池”:选择公共资源池或专属资源池,此处以公共资源池为例。

- “类型”:推荐选择gpu。

- “规格”:推荐选择gp tnt004规格,如果没有再选择其他规格。

- 参数填写完成后,单击“立即创建”进行规格确认。参数确认无误后,单击“提交”,完成notebook的创建操作。

进入notebook列表,正在创建中的notebook状态为“创建中”,创建过程需要几分钟,请耐心等待。当notebook状态变为“运行中”时,表示notebook已创建并启动完成。

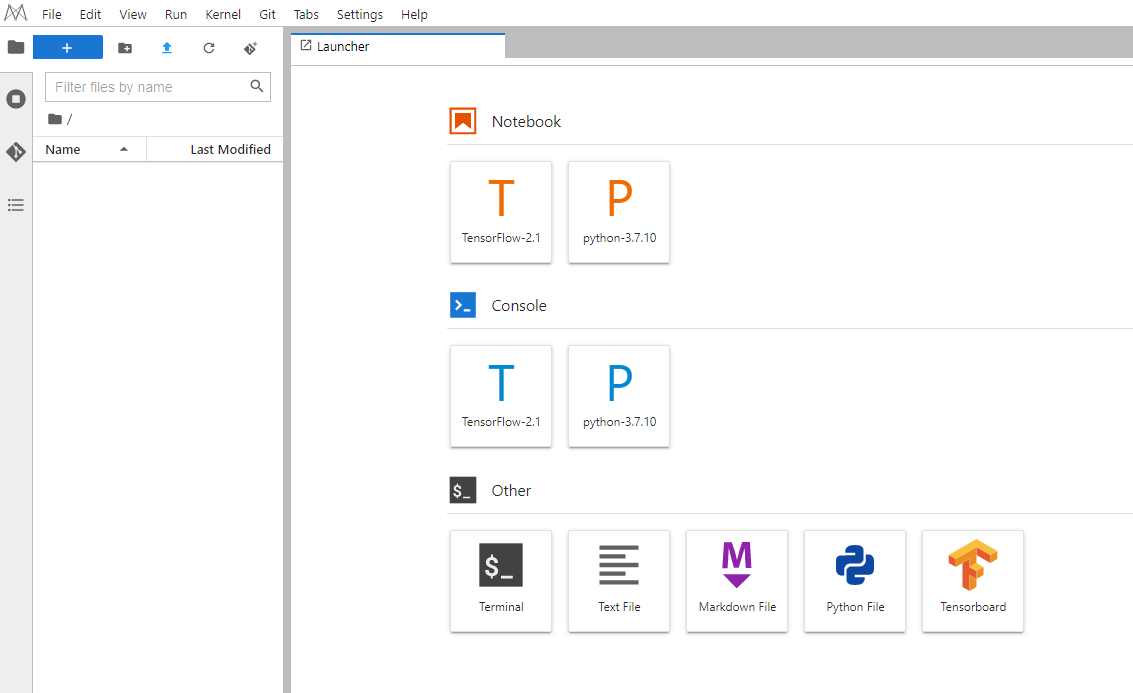

- 打开运行中的notebook实例。

图1 打开notebook实例

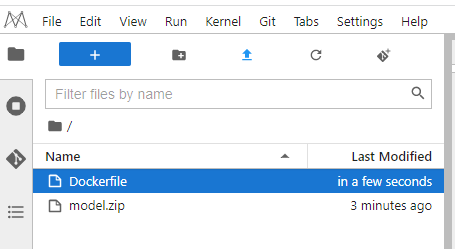

- 通过

功能,上传dockerfile文件和模型包文件到notebook中,默认工作目录/home/ma-user/work/。

功能,上传dockerfile文件和模型包文件到notebook中,默认工作目录/home/ma-user/work/。

dockerfile文件的具体内容请参见附录1:dockerfile模板。模型包文件需要用户自己准备,样例内容请参见附录2:模型包文件样例。

图2 上传dockerfile文件和模型包文件

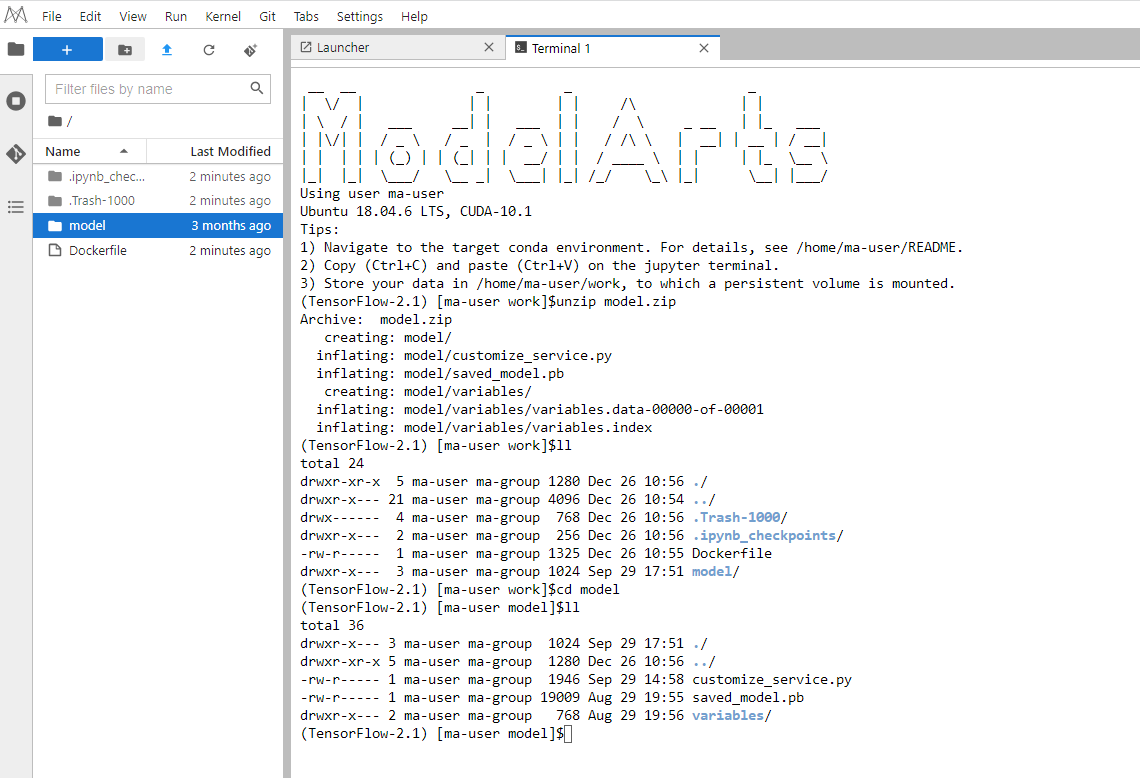

- 打开terminal终端,解压model.zip,解压后删除zip文件。

#解压命令 unzip model.zip

图3 在terminal终端中解压model.zip

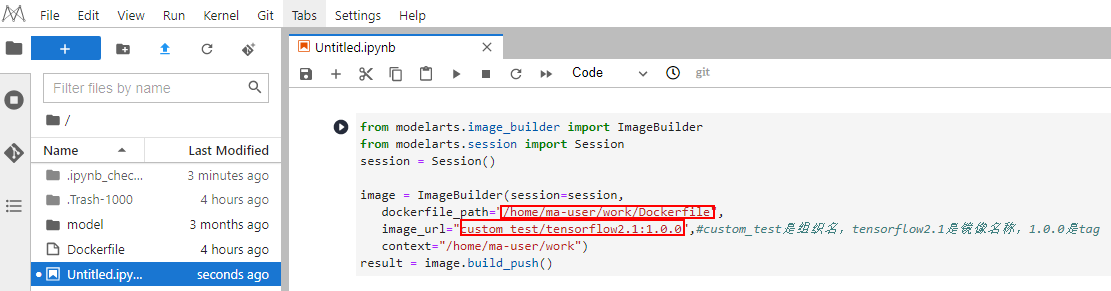

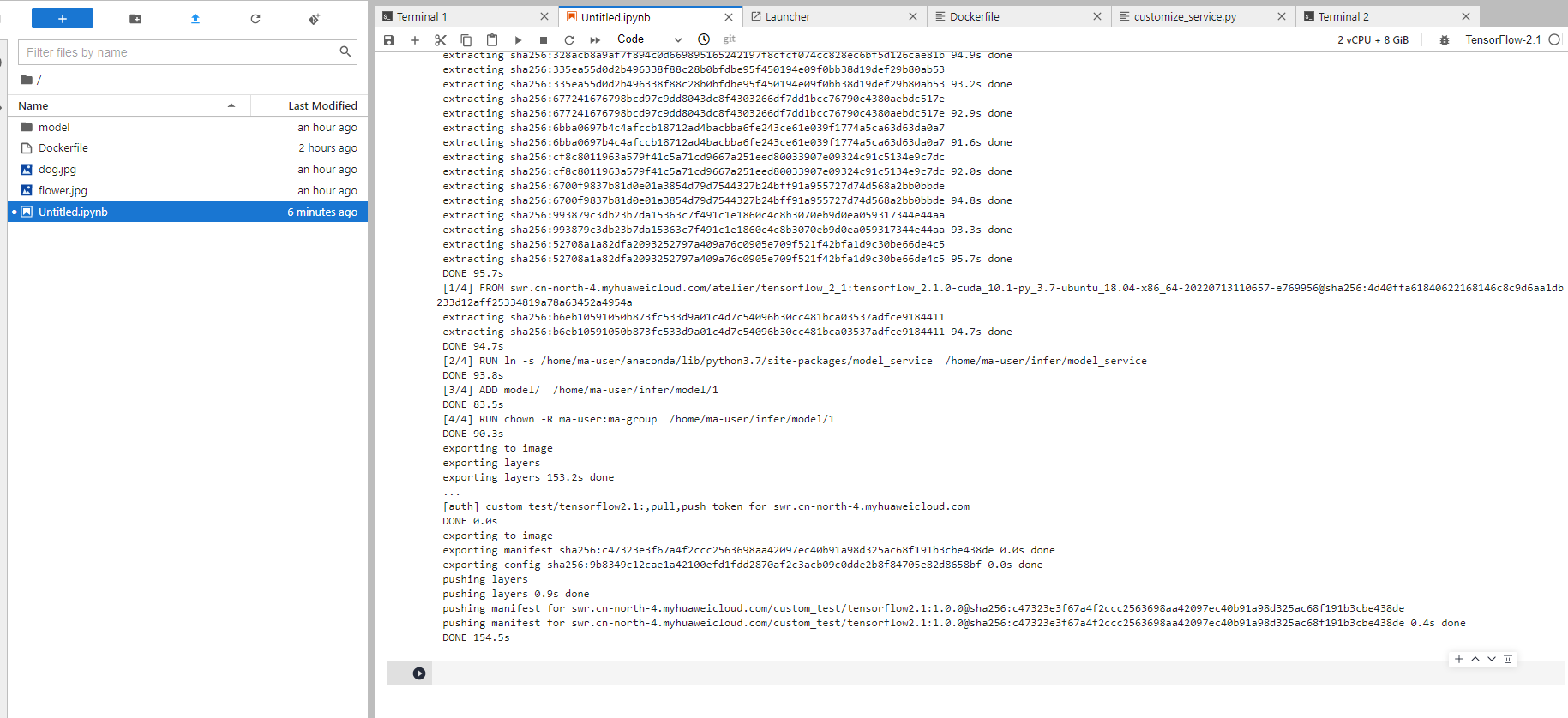

- 打开一个新的.ipynb文件,启动构建脚本,在构建脚本中指定dockerfile文件和镜像的推送地址。构建脚本当前仅支持华为云北京四和上海一站点。

图4 启动构建脚本

构建脚本内容如下:

from modelarts.image_builder import imagebuilder from modelarts.session import session session = session() image = imagebuilder(session=session, dockerfile_path="/home/ma-user/work/dockerfile", image_url="custom_test/tensorflow2.1:1.0.0",#custom_test是组织名,tensorflow2.1是镜像名称,1.0.0是tag context="/home/ma-user/work") result = image.build_push()

等待镜像构建完成。镜像构建完成后会自动推送到swr中。

图5 等待镜像构建完成

step2 构建成功的镜像注册到镜像管理模块

将step1 在notebook中构建一个新镜像中构建成功的自定义镜像注册到镜像管理中,方便后续使用。

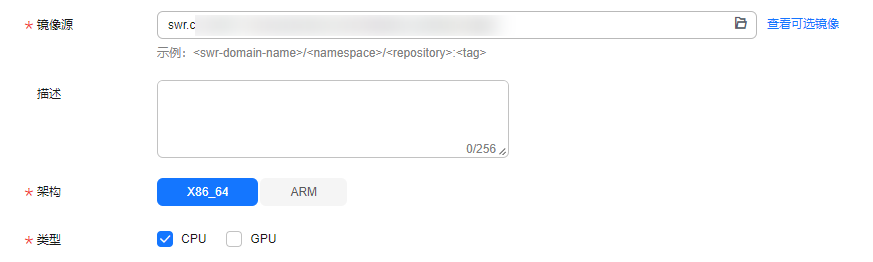

- 登录modelarts控制台,在左侧导航栏中选择“镜像管理”,单击“注册镜像”,进入注册镜像页面。

- 输入镜像源地址,选择架构和类型后,单击“立即注册”。

- “镜像源”:地址为swr.cn-north-4-myhuaweicloud.com/custom_test/tensorflow2.1:1.0.0。其中custom_test/tensorflow2.1:1.0.0为8镜像构建脚本中设置的镜像地址。

- “架构”:选择x86_64

- “类型”:选择cpu

图6 注册镜像

- 注册完成后,可以在镜像管理页面查看到注册成功的镜像。

step3 在notebook中变更镜像并调试

使用制作完成的自定义镜像进行推理服务调试,调试成功后再导入到modelarts的模型中并部署为在线服务。

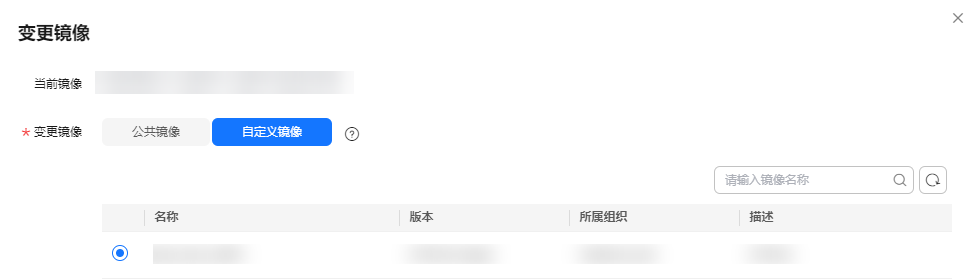

- 登录modelarts控制台,在左侧导航栏中选择“开发环境 > notebook”,进入“notebook”管理页面。停止step1 在notebook中构建一个新镜像中创建的notebook。

- 在notebook对应操作列,单击“更多 > 变更镜像”,打开“变更镜像”弹出框,变更镜像选择“自定义镜像”,将当前镜像变更为step2 构建成功的镜像注册到镜像管理模块注册的镜像,如图7所示。

图7 变更镜像

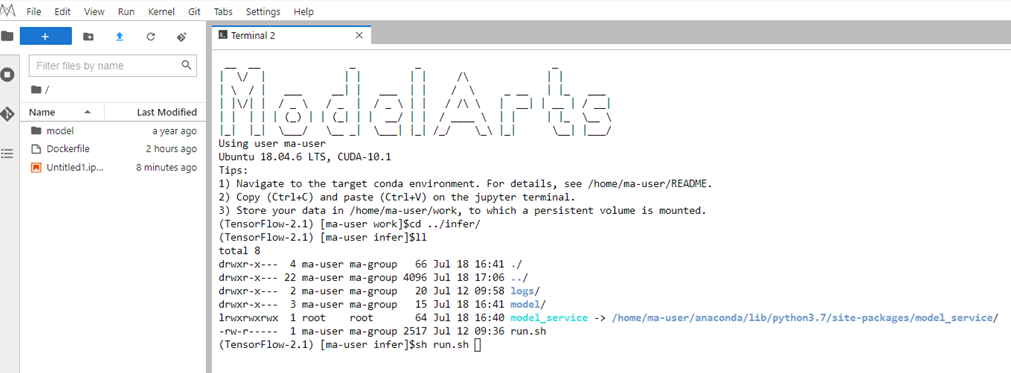

- 启动变更后的notebook,并打开。进入terminal运行界面,在工作目录,运行启动脚本run.sh,并预测模型。基础镜像中默认提供了run.sh作为启动脚本。

图8 运行启动脚本

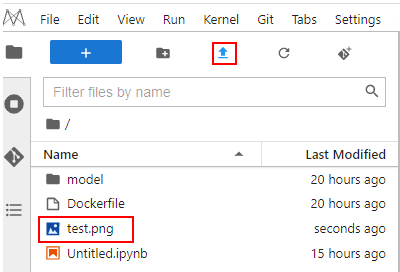

- 上传一张预测图片(手写数字图片)到notebook中。

图9 手写数字图片

图10 上传预测图片

图10 上传预测图片

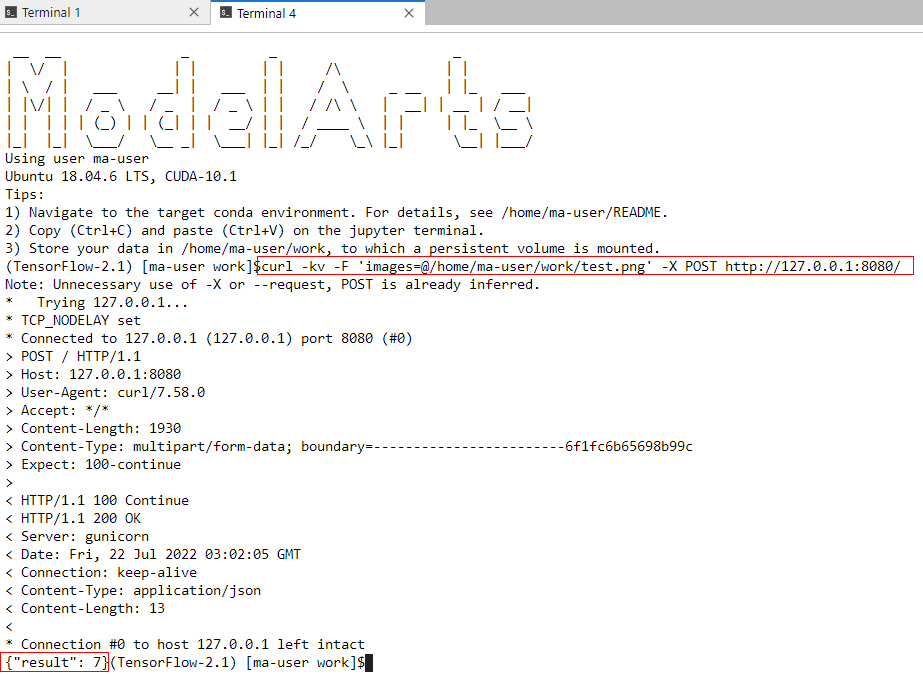

- 重新打开一个新的terminal终端,执行如下命令进行预测。

curl -kv -f 'images=@/home/ma-user/work/test.png' -x post http://127.0.0.1:8080/

图11 预测

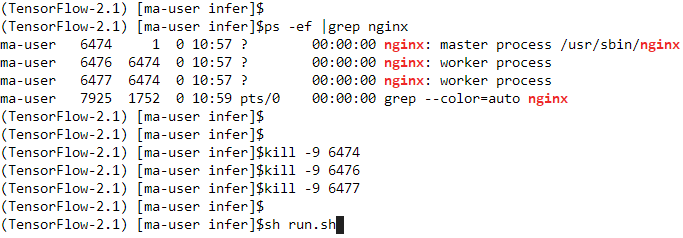

在调试过程中,如果有修改模型文件或者推理脚本文件,需要重启run.sh脚本。执行如下命令先停止nginx服务,再运行run.sh脚本。

#查询nginx进程 ps -ef |grep nginx #关闭所有nginx相关进程 kill -9 {进程id} #运行run.sh脚本 sh run.sh也可以执行pkill nginx命令直接关闭所有nginx进程。

#关闭所有nginx进程 pkill nginx #运行run.sh脚本 sh run.sh

图12 重启run.sh脚本

step4 使用调试成功的镜像用于推理部署

将step3 在notebook中变更镜像并调试中调试成功的自定义镜像导入到模型中,并部署为在线服务。

- 登录modelarts控制台,在左侧导航栏中选择“模型管理”,单击“创建”,进入模型管理。

- 设置模型的参数,如图13所示。

- 元模型来源:从容器镜像中选择。

- 容器镜像所在的路径:单击

选择前面创建的镜像。

选择前面创建的镜像。 - 容器调用接口:选择https。

- host:设置为8443。

- 部署类型:选择在线部署。

图13 设置模型参数

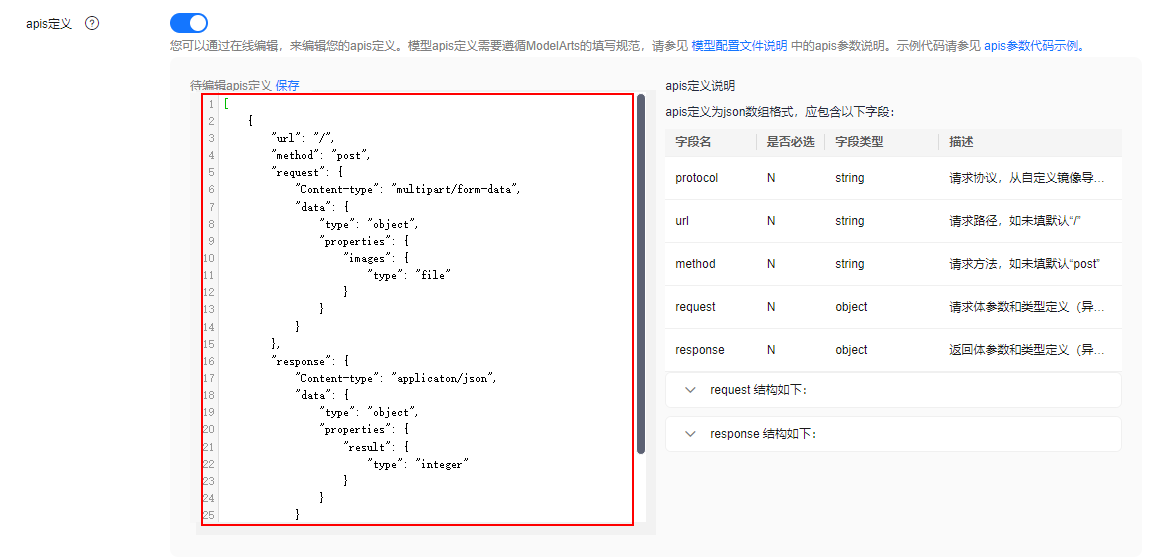

- 填写apis定义,单击“保存”生效。apis定义中指定输入为文件,具体内容参见下面代码样例。

图14 填写apis定义

apis定义具体内容如下:

[{ "url": "/", "method": "post", "request": { "content-type": "multipart/form-data", "data": { "type": "object", "properties": { "images": { "type": "file" } } } }, "response": { "content-type": "application/json", "data": { "type": "object", "properties": { "result": { "type": "integer" } } } } }]

apis定义提供模型对外restfull api数据定义,用于定义模型的输入、输出格式。

- 创建模型填写apis。在创建的模型部署服务成功后,进行预测时,会自动识别预测类型。

- 创建模型时不填写apis。在创建的模型部署服务成功后,进行预测,需选择“请求类型”。“请求类型”可选择“application/json”或“multipart/form-data”。请根据元模型,选择合适的类型。

- 选择“application/json”时,直接填写“预测代码”进行文本预测。

- 选择“multipart/form-data”时,需填写“请求参数”,请求参数取值等同于使用图形界面的软件进行预测(以postman为例)body页签中填写的“key”的取值,也等同于使用curl命令发送预测请求上传数据的参数名。

- 设置完成后,单击“立即创建”,等待模型状态变为“正常”。

- 单击新建的模型名称左侧的小三角形,展开模型的版本列表。在操作列单击“部署 > 在线服务”,跳转至在线服务的部署页面。

- 在部署页面,参考如下说明填写关键参数。

“名称”:按照界面提示规则自定义一个在线服务的名称,也可以使用默认值。

“资源池”:选择“公共资源池”。

“模型来源”和“选择模型及版本”:会自动选择模型和版本号。

“计算节点规格”:在下拉框中选择“限时免费”资源,勾选并阅读免费规格说明。

其他参数可使用默认值。

如果限时免费资源售罄,建议选择收费cpu资源进行部署。当选择收费cpu资源部署在线服务时会收取少量资源费用,具体费用以界面信息为准。

- 参数配置完成后,单击“下一步”,确认规格参数后,单击“提交”启动在线服务的部署。

- 进入“部署上线 > 在线服务”页面,等待服务状态变为“运行中”时,表示服务部署成功。单击操作列的“预测”,进入服务详情页的“预测”页面。上传图片,预测结果。

图15 预测

附录1:dockerfile模板

from swr.cn-north-4.myhuaweicloud.com/atelier/tensorflow_2_1:tensorflow_2.1.0-cuda_10.1-py_3.7-ubuntu_18.04-x86_64-20221121111529-d65d817 # here create a soft link from '/home/ma-user/anaconda/lib/python3.7/site-packages/model_service' to '/home/ma-user/infer/model_service'. it’s the build-in inference framework code dir # if the installed python version of this base image is python3.8, you should create a soft link from '/home/ma-user/anaconda/lib/python3.8/site-packages/model_service' to '/home/ma-user/infer/model_service'. user root run ln -s /home/ma-user/anaconda/lib/python3.7/site-packages/model_service /home/ma-user/infer/model_service user ma-user # here we supply a demo, you can change it to your own model files add model/ /home/ma-user/infer/model/1 user root run chown -r ma-user:ma-group /home/ma-user/infer/model/1 user ma-user # default modelarts_ssl_client_verify switch is "true". in order to debug, we set it to be "false" env modelarts_ssl_client_verify="false" # change your port and protocol here, default is 8443 and https # env modelarts_service_port=8080 # env modelarts_ssl_enabled="false" # add pip install here # run pip install numpy==1.16.4 # run pip install -r requirements.txt # default cmd, you can chage it here # cmd sh /home/ma-user/infer/run.sh

附录2:模型包文件样例

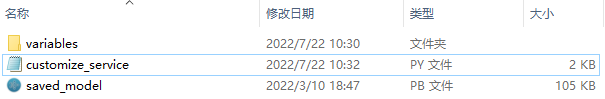

模型包文件model.zip中需要用户自己准备模型文件,此处仅是举例示意说明,以一个手写数字识别模型为例。

model目录下必须要包含推理脚本文件customize_service.py,目的是为开发者提供模型预处理和后处理的逻辑。

推理脚本customize_service.py的具体写法要求可以参考模型推理代码编写说明。

本案例中提供的customize_service.py文件具体内容如下:

import logging

import threading

import numpy as np

import tensorflow as tf

from pil import image

from model_service.tfserving_model_service import tfservingbaseservice

class mnist_service(tfservingbaseservice):

def __init__(self, model_name, model_path):

self.model_name = model_name

self.model_path = model_path

self.model = none

self.predict = none

# 非阻塞方式加载saved_model模型,防止阻塞超时

thread = threading.thread(target=self.load_model)

thread.start()

def load_model(self):

# load saved_model 格式的模型

self.model = tf.saved_model.load(self.model_path)

signature_defs = self.model.signatures.keys()

signature = []

# only one signature allowed

for signature_def in signature_defs:

signature.append(signature_def)

if len(signature) == 1:

model_signature = signature[0]

else:

logging.warning("signatures more than one, use serving_default signature from %s", signature)

model_signature = tf.saved_model.default_serving_signature_def_key

self.predict = self.model.signatures[model_signature]

def _preprocess(self, data):

images = []

for k, v in data.items():

for file_name, file_content in v.items():

image1 = image.open(file_content)

image1 = np.array(image1, dtype=np.float32)

image1.resize((28, 28, 1))

images.append(image1)

images = tf.convert_to_tensor(images, dtype=tf.dtypes.float32)

preprocessed_data = images

return preprocessed_data

def _inference(self, data):

return self.predict(data)

def _postprocess(self, data):

return {

"result": int(data["output"].numpy()[0].argmax())

}

相关文档

意见反馈

文档内容是否对您有帮助?

如您有其它疑问,您也可以通过华为云社区问答频道来与我们联系探讨