九游平台/

ai开发平台modelarts/

modelarts用户指南(standard)/

使用modelarts standard部署模型并推理预测/

将模型部署为实时推理作业/

实时推理的部署及使用流程

更新时间:2025-03-04 gmt 08:00

实时推理的部署及使用流程-九游平台

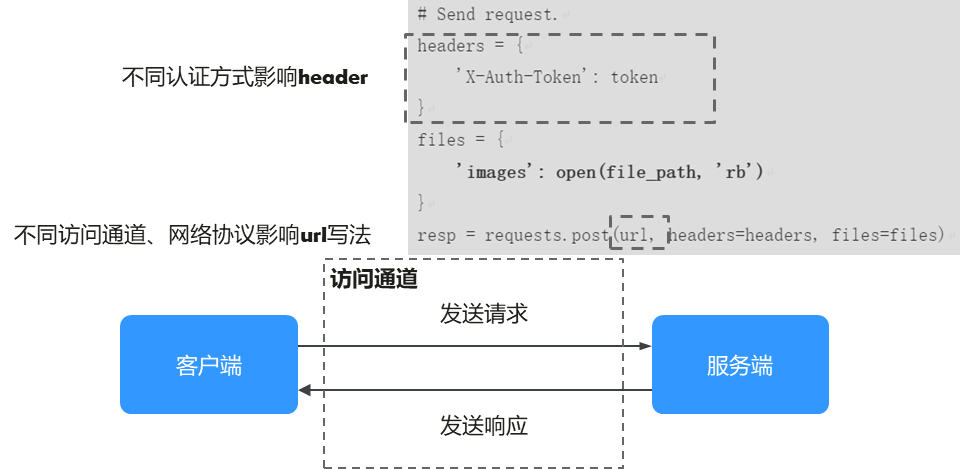

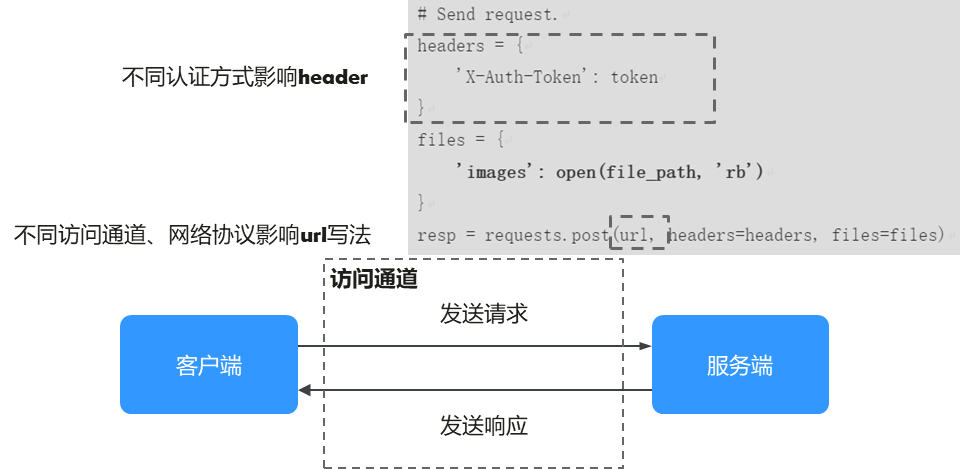

在创建完模型后,可以将模型部署为一个在线服务。当在线服务的状态处于“运行中”,则表示在线服务已部署成功,部署成功的在线服务,将为用户提供一个可调用的api,此api为标准restful api。访问在线服务时,您可以根据您的业务需求,分别确认使用何种认证方式、访问通道、传输协议,以上三个要素共同构成您的访问请求,三者可自由组合互不影响(例如不同的认证方式可以搭配不同的访问通道、不同的传输协议)。

图1 认证方式、访问通道、传输协议

当前modelarts支持访问在线服务的认证方式有以下方式(案例中均以https请求为例):

- token认证:token具有时效性,有效期为24小时,需要使用同一个token鉴权时,可以缓存起来,避免频繁调用。

- ak/sk认证:使用ak/sk对请求进行签名,在请求时将签名信息添加到消息头,从而通过身份认证。ak/sk签名认证方式仅支持消息体大小12m以内,12m以上的请求请使用token认证。

- app认证:在请求头部消息增加一个参数即可完成认证,认证方式简单,永久有效。

modelarts支持通过以下几种方式调用api访问在线服务(案例中均以https请求为例):

- 通过公网访问通道的方式访问在线服务:modelarts推理默认使用公网访问在线服务。在线服务部署成功后,将为用户提供一个可调用的api,此api为标准restful api。

- 通过vpc高速访问通道的方式访问在线服务:使用vpc直连的高速访问通道,用户的业务请求不需要经过推理平台,而是直接经vpc对等连接发送到实例处理,访问速度更快。

在线服务的api默认为https访问,同时还支持以下的传输协议:

- 使用websocket协议的方式访问在线服务:websocket使得客户端和服务器之间的数据交换变得更加简单,允许服务端主动向客户端推送数据。在websocket api中,浏览器和服务器只需要完成一次握手,两者之间就可以建立持久性的连接,并进行双向数据传输。

- 使用server-sent events协议的方式访问在线服务:server-sent events访问主要解决了客户端与服务器之间的单向实时通信需求(例如chatgpt回答的流式输出),相较于websocket(双向实时),它更加轻量级且易于实现。

父主题: 将模型部署为实时推理作业

相关文档

意见反馈

文档内容是否对您有帮助?

提交成功!非常感谢您的反馈,我们会继续努力做到更好!

您可在查看反馈及问题处理状态。

系统繁忙,请稍后重试

如您有其它疑问,您也可以通过华为云社区问答频道来与我们联系探讨